- Metropolis-Sampling

-

Der Metropolisalgorithmus ist eine Monte-Carlo-Methode zur Erzeugung von Zuständen eines Systems entsprechend der Boltzmann-Verteilung.

Inhaltsverzeichnis

Algorithmus

Der Metropolisalgorithmus wurde 1953 von Nicholas Metropolis et al. publiziert. Er wird dazu genutzt, eine Markow-Kette und damit die Zustände eines Systems entsprechend der Boltzmann-Verteilung zu erzeugen. Dabei hängt der neue Zustand des Systems xi + 1 nur vom vorherigen Zustand xi ab.

Im folgenden wird der Algorithmus für den Fall beschrieben, dass das System von einem mehrdimensionalen Ort x abhängt. x sei kontinuierlich und der aktuelle Ort nach i Iterationen wird mit xi bezeichnet. Der Metropolisalgorithmus ergibt sich dann durch Wiederholung der folgenden Schritte:

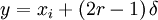

- Ein neuer Ort

wird ausgewählt, wobei r eine Zufallszahl zwischen 0 und 1 und δ ein fest gewählter Abstand ist. Dies bedeutet, dass ein neuer Ort zufällig in einer festen Umgebung gewählt wird, wobei die verschiedenen Komponenten der räumlichen Dimensionen nicht notwendigerweise gleich sein müssen.

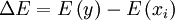

wird ausgewählt, wobei r eine Zufallszahl zwischen 0 und 1 und δ ein fest gewählter Abstand ist. Dies bedeutet, dass ein neuer Ort zufällig in einer festen Umgebung gewählt wird, wobei die verschiedenen Komponenten der räumlichen Dimensionen nicht notwendigerweise gleich sein müssen. - Die Energie-Differenz

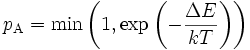

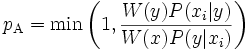

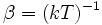

wird berechnet und die neue Konfiguration mit der Wahrscheinlichkeit

wird berechnet und die neue Konfiguration mit der Wahrscheinlichkeit  akzeptiert. Dabei beschreibt T die Temperatur des Systems und k stellt die Boltzmannkonstante dar. Dies bedeutet:

akzeptiert. Dabei beschreibt T die Temperatur des Systems und k stellt die Boltzmannkonstante dar. Dies bedeutet:

- Ist

, so wird y als neuer aktueller Ort akzeptiert.

, so wird y als neuer aktueller Ort akzeptiert. - Ist

, so wird y wird mit Wahrscheinlichkeit pA als neuer aktueller Ort akzeptiert. Dazu wird eine gerade ermittelte Zufallszahl zwischen 0 und 1 mit pA verglichen und y nur dann akzeptiert, falls die Zufallszahl kleiner als pA ist.

, so wird y wird mit Wahrscheinlichkeit pA als neuer aktueller Ort akzeptiert. Dazu wird eine gerade ermittelte Zufallszahl zwischen 0 und 1 mit pA verglichen und y nur dann akzeptiert, falls die Zufallszahl kleiner als pA ist.

- Ist

Falls der Zustand nicht akzeptiert wird, so bleibt der Wert von x erhalten: xi + 1 = xi.

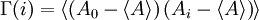

Kleine | δ | führen zu großen Akzeptanzraten, haben jedoch den Nachteil hoher Autokorrelationszeiten. Die Autokorrelationszeit

wird mit Hilfe der Autokorrelationsfunktion

wird mit Hilfe der Autokorrelationsfunktion  bestimmt. Große | δ | haben wiederum den Nachteil einer geringen Akzeptanzrate, so dass in der Praxis ein Mittelweg gesucht wird.

bestimmt. Große | δ | haben wiederum den Nachteil einer geringen Akzeptanzrate, so dass in der Praxis ein Mittelweg gesucht wird.Das oben beschriebene Verfahren lässt sich einfach auf andere Fälle, wie beispielsweise diskrete Zustände, übertragen. Für ein System aus vielen wechselwirkenden Teilchen wird der Metropolisalgorithmus lokal für ein einzelnes Teilchen angewandt und anschließend alle Teilchen - entweder nacheinander oder zufällig - durchlaufen.

Verallgemeinerung

W. Keith Hastings generalisierte 1970 das Verfahren. Der Metropolis-Hastings-Algorithmus kann Zustände für eine beliebige Wahrscheinlichkeitsverteilung W(x) erzeugen. Voraussetzung ist lediglich, dass die Dichte an jedem Ort x berechnet werden kann. Der Algorithmus benutzt eine Vorschlagsdichte P(y;xi), die vom derzeitigen Ort xi und möglichem nächsten Ort y abhängt. Beim Metropolis-Hastings-Algorithmus wird ein Vorschlag y anhand der Vorschlagsdichte zufällig erzeugt und mit der Wahrscheinlichkeit

akzeptiert.

akzeptiert.Für eine Vorschlagsdichte, die in einem festen Intervall um den aktuellen Ort konstant und sonst null ist, sowie einer Boltzmann-Verteilung als Wahrscheinlichkeitsverteilung ergibt sich hieraus der Metropolisalgorithmus.

Anwendungen

Monte-Carlo-Simulation

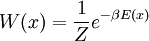

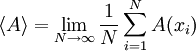

Bei Monte-Carlo-Simulationen werden Konfigurationen mittels des Metropolisalgorithmus erzeugt und Mittelwerte/Erwartungswerte physikalisch relevanter Größen, wie beispielsweise dem Druck oder Dichte, berechnet:

![\left\langle A \right\rangle = Z^{-1} \int [\mathrm{d} x] e^{-\beta E(x)} \, A(x)](/pictures/dewiki/51/363437967e758e46f895d25de9987170.png) mit

mit ![\ \ Z = \int [\mathrm{d} x] e^{-\beta E(x)}](/pictures/dewiki/101/ed215c64ef8575dba5e6b506a65284fa.png) und

und

Dazu werden von den Iterationsschritten des Metropolisalgorithmus zunächst so viele ausgeführt, bis sich das System dem thermischen Gleichgewicht genähert hat, d.h. die Wahrscheinlichkeit der einzelnen Konfigurationen der Boltzmann-Verteilung entspricht. Befindet sich das System im thermischen Gleichgewicht, so entspricht die Wahrscheinlichkeitsverteilung W(x) der Boltzmann-Verteilung, d.h. die Konfigurationen werden mit der Wahrscheinlichkeit

erzeugt (importance sampling) und es muss lediglich über jeden Messwert, bzw. Messwerte in konstantem Abstand, gemittelt werden:

erzeugt (importance sampling) und es muss lediglich über jeden Messwert, bzw. Messwerte in konstantem Abstand, gemittelt werden:  .

.Der Metropolisalgorithmus erzeugt Systeme im kanonischen Zustand, d.h. mit konstanter Temperatur. Um mikrokanonische Zustände zu erzeugen, können Molekulardynamik-Algorithmen verwendet werden.

In der Originalarbeit von Nicholas Metropolis et. al. wurde der Algorithmus für die Monte-Carlo-Simulation des zweidimensionalen Harte-Scheiben-Modells verwendet. Der Algorithmus wurde später für eine Vielzahl unterschiedlichster Monte-Carlo-Simulationen in Bereichen wie z.B. der Thermodynamik bzw. Statistischen Physik, Festkörperphysik, Quantenelektrodynamik oder Quantenchromodynamik eingesetzt. Dabei muss der Algorithmus gegebenenfalls angepasst werden, wie die Energie durch den Hamiltonoperator oder die Wirkung ersetzt werden. Der Metropolisalgorithmus ist leicht zu implementieren, jedoch nicht der effektiveste Algorithmus. Alternativ können andere lokale oder nicht-lokale Verfahren Verwendung finden.

Optimierungsverfahren

Der Metropolisalgorithmus kann auch als stochastisches Optimierungsverfahren zum Finden eines globalen Minimums einer Wertelandschaft verwendet werden. Hierzu wird mit einer hohen Temperatur begonnen, damit möglichst ein großes Gebiet der Wertelandschaft besucht wird. Anschließend wird die Temperatur langsam abgesenkt und sich so mit immer höherer Wahrscheinlichkeit einem Minimum genähert. Ein solcher Metropolisalgorithmus mit von der (Simulations-) Zeit abhängiger Temperatur heißt simulierte Abkühlung (simulated annealing). Für bestimmte Formen der simulierten Abkühlung konnte bewiesen werden, dass sie das globale Minimum einer Wertelandschaft finden.

Das Verfahren ähnelt dem Bergsteigeralgorithmus (hill climbing), akzeptiert jedoch im Gegensatz zu diesem auch Schritte weg vom nächsten Minimum, so dass frühzeitige Konvergenz zu lokalen Minima vermieden wird. Der Metropolisalgorithmus überwindet so kleine Hügel, bevor weiter in Richtung Tal gegangen wird, da der Anstieg in Richtung Hügel klein ist und somit die Akzeptanz-Wahrscheinlichkeit relativ groß ist.

Siehe auch

Literatur

- N. Metropolis, A. Rosenbluth, M. Rosenbluth, A. Teller und E. Teller: Equation of State Calculations by Fast Computing Machines. In: Journal of Chemical Physics. 21, 1953, S. 1087-1092 (doi:10.1063/1.1699114).

- W.K. Hastings: Monte Carlo Sampling Methods Using Markov Chains and Their Applications. In: Biometrika. 57, 1970, S. 97-109.

- Ein neuer Ort

Wikimedia Foundation.