- Digitale Bildverarbeitung

-

Die (digitale) Bildverarbeitung nutzt die Mittel der Signalverarbeitung zur Aufbereitung - dies sind Bildvorverarbeitungsroutinen wie Kalibrierung, Restauration, Rekonstruktion - zur Speicherung und zur Darstellung von visuellen 2D- bzw. 3D- Informationen aus digitalisierten Daten verschiedenster Art.

Im Gegensatz zur Bildbearbeitung, welche sich mit der Manipulation von Bildern zur anschließenden Darstellung beschäftigt, umfasst die Bildverarbeitung weitergehende Bearbeitungsprozeduren zur Extraktion von Information aus den Ursprungsdaten: z. B. Bewegungsbestimmung, Bildsegmentierung, Bilderkennung und Mustererkennung).

Bildverarbeitung wird mittlerweile in nahezu allen Wissenschafts- und Ingenieursdisziplinen eingesetzt, wie beispielsweise in der modernen Mikroskopie, medizinischen Diagnostik, Astronomie, Maschinenbau und in der Fernerkundung (Umweltbeobachtung, Spionage). Mit Methoden der Bildverarbeitung werden in Maschinen Objekte gezählt, vermessen, Objekte inspiziert oder codierte Informationen gelesen. Röntgen- und Ultraschallgeräte liefern mit der Bildverarbeitung Bilder, die der Arzt einfacher deuten kann. Röntgengeräte in Sicherheitszonen untersuchen Gepäck und Kleidung automatisch nach gefährlichen Objekten (Waffen etc.). Ein weiteres Feld ist die Qualitätssicherung in Fertigungs- und Produktionsprozessen.

Inhaltsverzeichnis

Anwendungsbeispiele der Bildverarbeitung

Inspektion und Vermessung von Objekten

Vermessung von Chips in der Halbleiterfertigung: Es wird zum Beispiel die Position der Ecke eines Chips in einem Bild gemessen. Mit dieser Information kann dieser Chip präzise zur Bestückung positioniert werden. Bei der Chip-Endkontrolle werden Fehler beim Löten und Bonden detektiert, indem ein Chip vor die Kamera gefahren wird und mit einem 'Golden Sample' verglichen wird, das zuvor vom Bildverarbeitungssystem eingelernt wurde. Oder es wird dabei nach eindeutig definierten geometrischen Mustern (Kreis, Ecke..), nach Rissen oder Ausbrüchen gesucht.

Bildverarbeitung in einer Bier-Abfüllanlage: Um zu prüfen, ob in jeder Flasche gleich viel Bier eingefüllt wurde, wird ein Bild des Flaschenhalses gemacht und die Flüssigkeitskante gemessen. Vor der Abfüllung wird geprüft ob der Flaschenhals Risse oder Absplitterungen aufweist.Vermessung von Kleber in der Mikromechanik: Bei der Fertigung von Kameramodulen für Mobiltelefone wird Kleber auf den Linsenhalter aufgetragen. Um eine gleichmäßige Qualität der Produktion zu gewährleisten wird die Form dieses Klebers in einem Bild geprüft. Wenn der Kleberauftrag nicht innerhalb gewisser Toleranzen liegt wird das Bauteil ausgeschieden.

Lesen von codierten Informationen

Mittels Bildverarbeitung können aus Bildern codierte Informationen automatisiert ausgelesen werden. Zum Beispiel kann ein in DataMatrix-Form codierter Text ausgelesen werden oder Information mittels OCR als Klartext extrahiert werden.

In der Automobilfertigung werden z. B. Seriennummern von Bauteilen in DataMatrix-Form codiert. Wenn eine Baugruppe einen Fertigungsbereich erreicht, wird mit einer Kamera ein Bild des Codes aufgenommen und der Code ausgelesen. Mit dieser Seriennummer erhalten Maschinen des Fertigungsbereichs von einem Server Informationen, wie die Baugruppe zu behandeln ist.

Objekte der Bildverarbeitung

Die in der Bildverarbeitung manipulierten Objekte lassen sich nach verschiedenen Gesichtspunkten klassifizieren:

Typ

- Reflexionsbilder (z. B. Kameraaufnahmen, Radaraufnahmen, Multispektralaufnahmen)

- Projektionsbilder (z. B. Röntgenaufnahmen, Ultraschall, Elektrophoretogramme)

- Schematisierte Bilder (z. B. Karten, Pläne, Dokumente)

Manchmal findet sich auch die Unterscheidung zwischen Reflexions- (s. o.), Absorptions- (Röntgen), und Emissionsbildern (astronomische Aufnahmen, Nuklearaufnahmen) in der Fachliteratur.

Codierung

- Rasterbilder (z. B. konventionell auf quadratischem Gitter)

- Kettenkodierung (durch Richtungsangaben beschriebene Bildlinien)

- Transformationskodierung (Ergebnis einer Reihenentwicklung)

- Fraktale Kodierung (Ausnutzung von Selbstähnlichkeit)

Operationen der Bildverarbeitung

Die Operationen in der Bildverarbeitung lassen sich in drei Klassen einteilen: Punktoperatoren, lokale Operatoren und globale Operatoren. Diese Einteilung basiert darauf, wie viele Bildpunkte bei dem jeweiligen Verfahren für die Berechnung eines neuen Grau- oder Farbwertes f(x, y) eines Bildpunktes (x, y) betrachtet werden.

Punktoperatoren transformieren jeden Punkt eines Bildes einzeln nur in Abhängigkeit vom Grau- oder Farbwert und ggf. der Position im Bild. Beispiele hierfür sind Histogrammtransformationen wie die Histogrammspreizung oder die Histogrammäqualisation.

Lokale Operatoren berechnen einen neuen Farb- oder Grauwert eines Bildpunktes immer auf Basis einer Nachbarschaft oder einer örtlich begrenzten Region um den Punkt. Hier seien als Beispiele Rangordnungsoperatoren oder morphologische Operatoren genannt.

Globale Operatoren betrachten für die Transformation eines jeden Pixels immer das gesamte Bild, was beispielsweise bei der Fourier-Transformation der Fall ist.

Punktoperatoren

- Hauptartikel: Punktoperator (Bildverarbeitung)

Ein Punktoperator T ordnet einem Eingabebild f durch Transformation der Grauwerte der einzelnen Pixel ein Ergebnisbild f* zu. Der Grauwert f(x, y) eines Pixels (x, y) wird dabei nur in Abhängigkeit vom Grauwert selbst und eventuell von der Position des Pixels im Bild modifiziert:

- f * (x,y) = Txy(f(x,y))

Ist die Transformation von der Position des Pixels im Bild abhängig, so heißt sie inhomogen. Die Indizes x und y von T sollen diese Abhängigkeit verdeutlichen. In der Mehrheit der Fälle kommen jedoch homogene Transformationen zum Einsatz, bei denen diese Abhängigkeit nicht gegeben ist. Die Indizes werden dann überflüssig:

- f * (x,y) = T(f(x,y))

Histogramm

In der digitalen Bildverarbeitung versteht man unter einem Histogramm die statistische Häufigkeit der einzelnen Grau- bzw. Farbwerte in einem Bild. Das Histogramm eines Bildes erlaubt eine Aussage über die vorkommenden Grau- bzw. Farbwerte und über Kontrastumfang und Helligkeit des Bildes.

Typische Punktoperatoren bewirken eine sichtbare Änderung im Histogramm. So wird es bei einer Histogrammspreizung zwecks Erhöhung des Kontrasts auseinandergezogen oder bei einer Histogrammverschiebung zwecks Helligkeitskorrektur durch Addition einer Konstante verschoben. Eine klassische Anwendung von Histogrammen in der Bildverarbeitung liegt in der Äqualisation (auch Egalisierung oder Einebnung genannt), bei der eine Gleichverteilung der Grau- bzw. Farbwerte berechnet wird. Dadurch kann eine bessere Verteilung der Farbgebung erreicht werden, die über eine bloße Kontrastverstärkung hinausgeht.

Schwellwertoperationen

- Hauptartikel: Schwellwertverfahren

Sollen Bilder in kleinere Farbräume konvertiert werden, ergibt sich das Problem der Bestimmung adäquater Schwellwerte. Eine klassische Aufgabe ist die Binarisierung eines Grauwertbildes. Typische Schwellwerte können aus dem Grauwerthistogramm eines Bildes gewonnen werden:

- Mittelmäßiger Grauwert

- Mittlerer oder erwarteter Grauwert

- Grauwertmedian

- Hauptsenken (zentralste relative Extremstellen des Grauwerthistogramms)

- Maximum-Entropie-Schwellwert

Andere Methoden bieten ein „Grauwertmischverteilungsmodell“ oder der Intermeans-Algorithmus.

Lokale Operatoren

Filter

Die Operationen, die ein Eingangsbild mit Hilfe einer mathematischen Abbildung in ein Ausgabebild überführen, heißen Filter. Die folgenden Filter beziehen sich im Wesentlichen auf Rasterbilder.

Ziel einer Filterung ist im Allgemeinen eine Verbesserung eines Musters. Im Einzelnen kann dies eine Reduktion störender Anteile, eine Hervorhebung informativer Anteile bzw. die Restaurierung eines idealen Musters sein. Die Abbildung welche ein gegebenes Bild auf ein Ausgabebild abbildet, heißt Transformation.

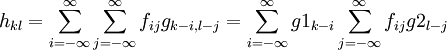

Die Funktionsfamilie gμ mit

heißt Impulsantwort des linearen Systems

heißt Impulsantwort des linearen Systems  .

.  ist die Diracsche Deltafunktion mit Impuls bei x = μ.

ist die Diracsche Deltafunktion mit Impuls bei x = μ.Separierbarkeit

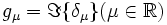

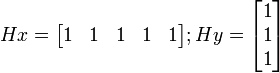

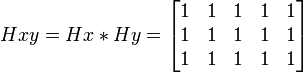

In der Praxis nutzt man gerne separierbare Filter. Separierbar ist ein Filter immer dann, wenn man die Impulsantwort gij folgendermaßen ausdrücken kann:

- gi,j = g1ig2j

Es gilt dann:

Man kann dann die 2D-Faltung aufspalten in zwei 1D-Faltungen. Dies verringert den Aufwand einer Faltung bei einem Bildpunkt von M·N auf M+N Multiplikationen. Wobei M die Breite und N die Höhe der FIR-Filtermatrix ist.

Ein Beispiel dazu:

Dadurch, dass die Faltung assoziativ ist, können die einzelnen Filter zusammengesetzt werden.

Wie wir sehen haben wir bei der Verwendung der zwei kleinen Filter nur 8 Operationen. Bei der Verwendung der großen Matrix 15.

Nichtlineare Filter

Morphologische Operationen

Während Grauwertrasterbilder für gewöhnlich als Abbildung von Koordinatenpaaren auf Farbwerte dargestellt werden, bietet sich für Binärbilder eine Darstellung als Menge der gesetzten Pixel an. Operationen können dann als Mengenoperation zwischen den Rasterpunktmengen des Binärbildes und eines Strukturelementes beschrieben werden. Aus den Basisoperationen der Morphologischen Bildverarbeitung, der Erosion und Dilatation, lassen sich die Operationen Öffnen, Schließen und schließlich die Morphologische Glättung definieren.

Filter nach Anwendungsgebieten

Glättung

Durch Glättung kann das Bildrauschen vermindert werden, grobere Strukturen bleiben dagegen erhalten. Hier ein Beispiel für ein (künstlich) verrauschtes Bild. Auf das Frequenzspektrum eines Bildes bezogen kommt eine Glättung einem Tiefpassfilter gleich. Typische FIR-Glättungsfilter sind

- Mittelwertfilter (box filter): Ein Mittelwertfilter der Größe

wird durch eine

wird durch eine  -Impulsantwortmatrix gnm = (nm) − 1 beschrieben. Die Bildpunkte des transformierten Bildes sind somit die Mittelwerte ihrer

-Impulsantwortmatrix gnm = (nm) − 1 beschrieben. Die Bildpunkte des transformierten Bildes sind somit die Mittelwerte ihrer  Nachbarn. Box-Filter sind nicht isotrop und nicht abklingend und stellen entgegen einer naiven Einschätzung keinen eigentlichen Tiefpassfilter dar.

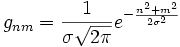

Nachbarn. Box-Filter sind nicht isotrop und nicht abklingend und stellen entgegen einer naiven Einschätzung keinen eigentlichen Tiefpassfilter dar. - Gauß-Filter: Gaußfilter der Größe

und einer Varianz σ2 werden durch eine Impulsantwortmatrix

und einer Varianz σ2 werden durch eine Impulsantwortmatrix  beschrieben. Die Nachbarpunkte des Ausgangsbildes gehen damit nicht wie beim box-filter gleichwertig ein, sondern werden entsprechend einer zweidimensionalen Gaußglocke gewichtet. Gauß-filter sind damit isotrop und abklingend. Sie werden als reales optisches Bauteil als Gauß-Filterung der Fourier-Transformierten in der Apodisation eingesetzt. (Beispiel).

beschrieben. Die Nachbarpunkte des Ausgangsbildes gehen damit nicht wie beim box-filter gleichwertig ein, sondern werden entsprechend einer zweidimensionalen Gaußglocke gewichtet. Gauß-filter sind damit isotrop und abklingend. Sie werden als reales optisches Bauteil als Gauß-Filterung der Fourier-Transformierten in der Apodisation eingesetzt. (Beispiel).

- Nichtlineare Glättungsfilter, der Grauwert des aktuellen Pixels wird dabei ersetzt durch

- Medianfilter

- den Median der Grauwerte der aktuellen Umgebung (Beispiel)

- k-zentriertes Mittel

- den Durchschnitt der k-mittleren Grauwerte

- k-NN-Filter

- der Median der k-nächsten Grauwerte der Umgebung

- δ-Nachbarschaftsfilter

- den Durchschnitt aller Grauwerte deren Abstand kleiner als δ zum aktuellen Grauwert ist

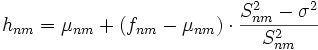

- Lee's Filter

- μnm ist Grauwertmittel,

Grauwertvarianz und σ2 Rauschenergie der aktuellen Umgebung

Grauwertvarianz und σ2 Rauschenergie der aktuellen Umgebung

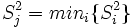

- Minimum-Varianz-Filter

- es werden die Grauwertmittel μi und Varianzen

einiger Teilfenster berechnet

einiger Teilfenster berechnet - hnm = μj wird gewählt mit

- es werden die Grauwertmittel μi und Varianzen

- Medianfilter

Kantenhervorhebung

Werden anstatt der absoluten Farbwerte die Abweichung zu den benachbarten Punkten signalisiert, so werden die Objektkonturen, d. h. harte Farbübergänge, eines Bildes hervorgehoben, während weiche Übergänge abgeschwächt werden. Dieser Vorgang wird als Kantenhervorhebung bezeichnet.

Häufig finden folgende FIR-Filter Anwendung:

- Ableitungsfilter

- Laplace-Filter

Nichtlineare Kantendetektoren:

- Varianzfilter

- Extremalspannenfilter

- Roberts-Kreuz

- Kirsch-Filter

- Gradientenfilter

Globale Operationen

Fourier-Transformation

Werden Bilder als Folge von Farbwerten dargestellt, spricht man von einer Darstellung im Zeit-, Impuls- oder auch Orts-Raum. Aus diesem lassen sich Bilder injektiv in den sogenannten Frequenz-Raum überführen, in welchem nicht mehr die Farbwerte selbst, sondern die Frequenz- und Phasenanteile der zugrundeliegenden Punktfolge gespeichert werden. Große Sprünge innerhalb der Farbwertsequenz stehen dann für hohe Frequenzen, weiche Farbwertübergänge für niedrige Frequenzen. Die Fourier-Transformierte gibt schließlich an, wie durch alleinige Überlagerung von Sinusfunktionen verschiedener Frequenz und Phasenwinkel, der ursprüngliche Farbwertverlauf rekonstruiert werden kann.

Der Vorteil dieser Darstellung liegt in ihrer höheren Effizienz bei der Anwendung linearer Filter. Im Impuls-Raum bedeutet die Faltung der das Bild beschreibenden Farbwertfolge fi mit der Impuls-Antwort gμ(der Transformationsabbildung) des Filters eine Summation (der Gewichtung der Impulse mit der Impulsantwort) über die gesamte Filterlänge. Im Frequenzraum hingegen berechnet sich die Faltung als Produkt der Fourier-Transformierten mit der Frequenzantwort der Transformation

. Dieser Vorteil bezüglich der Rechenzeit ist so groß, dass selbst der Aufwand der Hin- und Rücktransformation in den Frequenzraum in Kauf genommen werden kann. Dieser Aufwand lässt sich mit Hilfe der schnellen Fourier-Transformation (FFT) deutlich senken.

. Dieser Vorteil bezüglich der Rechenzeit ist so groß, dass selbst der Aufwand der Hin- und Rücktransformation in den Frequenzraum in Kauf genommen werden kann. Dieser Aufwand lässt sich mit Hilfe der schnellen Fourier-Transformation (FFT) deutlich senken.Von Vorteil ist des Weiteren die Vereinfachung, Filter direkt im Frequenzraum designen zu können, anstatt Impulsantworten bauen und ihre Wirkung auf das Spektrum berechnen zu müssen. Damit erübrigt sich gleichsam die Transformation der Impulsantwort gk in die zugehörige Frequenzantwort G(z).

Radontransformation

- Hauptartikel: Radontransformation

Transformation

Transformationen von diskreten Bildern gestalten sich gegenüber stetigen Bildern ungemein schwieriger, da Transformationen im Allgemeinen nicht gitterkonform sind. Neben der eigentlichen Transformation muss daher geeignet interpoliert werden. Typische Transformationen sind:

- Translation

- Rotation

- Skalierung

- Neigung

Normierung

Eine Meta-Manipulation von Bildern stellt das Feld der Normierung dar. Sie dient dem Abstrahieren von irrelevanten Eigenschaften und der Reduktion von Mustervariabilität. Unproduktive Parameter werden dabei auf einen Standardwert gesetzt. Sie ist damit in der Mustererkennung als Vorverarbeitung von großer Bedeutung. Normierbare Parameter sind unter anderen Intensität, Größe, Lage oder Dicke/Stärke.

Klassifikation

Mit Hilfe der Klassifikation (auch Klassifizierung) soll das breite Informationsspektrum eines Originalbildes durch Einteilung von Farb- oder Grauwerten in Klassen vereinfacht werden. Ziel ist es, Flächen mit gleichen bzw. ähnlichen Eigenschaften zu ermitteln und diese verschiedenen Klassen zuzuordnen. Klassifikatoren werden nicht programmiert, sondern anhand von Beispieldaten trainiert. Es gibt zwei Arten, um Klassifikatoren zu trainieren, das unüberwachte und das überwachte Training.

Unüberwachtes Training

Beim unüberwachten Training werden die Klassen über eine Clusteranalyse gebildet. Die Folge ist, dass die resultierenden Klassen nicht beeinflussbar sind, das Ergebnis also nicht vorhersehbar ist. Wenn eine funktionelle Klassifikation gewünscht ist, das heißt die Klassen bestimmten realen Klassen entsprechen sollen (wichtig in der Fernerkundung, um bspw. Nutzungsklassen auf einem Satellitenbild zu identifizieren) müssen die Ergebnis-Klassen anschließend durch Vergleiche mit den Real-Klassen aufwändig ermittelt werden.

Grundsätzlich gibt es divisive Verfahren, bei denen eine anfängliche Gesamtklasse sukzessive in Unterklassen aufgeteilt wird, und agglomerative Verfahren, bei denen die Klassen (zu beginn so viele, wie es Elemente/Pixel gibt) sukzessive bis zu einer Gesamtklasse zusammengefasst werden.

Überwachtes Training

Das überwachte Training besteht aus zwei Schritten:

- Zuerst werden die Zielklassen mit den jeweiligen (Farb-)Merkmalen durch eine Auswahl so genannter "Trainingsflächen" festgelegt. Dabei sollte möglichst die gesamte Varianz einer Klasse erfasst, die Auswahl von "Mischpixeln" aber vermieden werden.

- Anschließend erfolgt die Zuweisung aller Pixel zu den entsprechenden Klassen. Dafür gibt es verschiedenen Methoden, z. B.:

-

-

- die Maximum-Likelihood-Methode: Zuweisung anhand der größten Zugehörigkeitswahrscheinlichkeit

- die Minimum-Distance-Methode: Zuweisung anhand des nächstliegenden Klassenmittelpunktes

- die Quader-Methode: Zuweisung anhand von Ober- und Untergrenzen der einzelnen Klassen

- Künstliche neuronale Netze: iterative Optimierung der Verbindung zwischen den einzelnen Einheiten (Pixeln)

-

Güte der Klassifikation

Der aus dem Training resultierende Klassifikator sollte immer hinsichtlich Sensitivität und Spezifität analysiert werden. Eine Bewertung der Generalisierungseigenschaften und der Qualität von verschiedenen Klassifkatoren kann unter Verwendung von Resampling-Verfahren erfolgen.

Beispiele

Anwendung eines 3x3 Medianfilters auf das verrauschte Bild.

Siehe auch

- Grafik-Software

- Bildauflösung

- Bildsegmentierung

- Bildregistrierung

- Computervisualistik

- Snakes

- Musteranalyse

Literatur

- Bernd Jähne: Digitale Bildverarbeitung. 6. Auflage. Springer, 2005, ISBN 978-3-540-24999-3.

Weblinks

Wikimedia Foundation.