- Computermusik

-

Computermusik ist Musik, zu deren Entstehung die Verwendung von Computersystemen notwendig oder wesentlich ist. Der Begriff der elektronischen Musik bezieht sich dagegen allgemeiner auf die elektronische Erzeugung der Klangsignale.

Inhaltsverzeichnis

Geschichte

Bereits im 17. Jahrhundert wuchs die Überzeugung, dass Musik die Kunst geschickter Zahlenordnungen ist. Als einen der frühesten Überlieferungen dieser Art gilt die Arca Musarithmica, die in der 1650 gedruckten Musurgia Universalis des Jesuitenpater und Musikgelehrten Athanasius Kircher erwähnt wurde. Ebenso sind von Caspar Schott Schriften zu mechanischen Musikinstrumenten überliefert.

Nach 1770 verlagerte sich das Zentrum von Musikautomaten von Deutschland nach Frankreich, England und in die Schweiz. Erwähnenswert sind die Erfindungen des Franzosen Vaucanson. Bei einigen Erzählungen E. T. A. Hoffmanns war der mechanische Automat deren Gegenstand.

Unter anderen soll Wolfgang Amadeus Mozart sich ein Musikalisches Würfelspiel (KV 294 d) ausgedacht haben, eine „Anleitung, Walzer oder Schleifer mit zwei Würfeln zu componieren ...“. Dort sind in einer Tabelle 3/8-Takte im Klaviersatz aufgelistet, deren Auswahl durch die Augenzahl der geworfenen Würfel geschieht und hintereinander notiert, eine fertige Komposition ergeben.

Wenn nun der Computer „würfelt“, d. h. Zufallszahlen erzeugt, entsprechen den Zahlen Noten. Gleichzeitig werden dem Computer Regeln beigebracht, die darüber befinden, welche der erwürfelten Noten zugelassen werden und welche ggf. verworfen werden, da sie in dem Fall den Regeln widersprechen. Die Regeln können einem Lehrbuch entnommen sein, oder man programmiert den Computer so, dass er z. B.nach Eingabe eines Bachchorals die dortigen Regeln und Bedingungen selber findet, etwa welche Harmonien vorkommen, welche Tonfolgen öfter auftreten, usw. Der russische Mathematiker Andrei Andrejewitsch Markow führte im Zusammenhang mit Textuntersuchungen die nach ihm benannten Markow-Ketten ein, bei denen Übergangswahrscheinlichkeiten für einzelne Elemente betrachtet werden. Claude Elwood Shannon, der Begründer der Informationstheorie, hat dann darauf hingewiesen, dass die Markowmethode auch bei musikalischen Experimenten Anwendung finden könnte.

Im August 1951 wurde mit dem australischen CSIRAC (Council for Scientific and Industrial Research Automatic Computer) öffentlich Musik wiedergegeben.[1]

Lejaren A. Hiller und Leonard M. Isaacson schließlich nannten den vierten (Experimenten-)Satz ihrer ILLIAC-Suite für Streichquartett (die erste, 1955/1956 entstandene Computerkomposition) dementsprechend Markov chain music. Im ersten und zweiten Satz dominierten hier die Palestrina-Kontrapunktregeln, welche Johann Joseph Fux in seinem berühmten Werk Gradus ad Parnassum formuliert hatte. Im dritten und vierten Satz dominierten neuzeitlichere Kompositionsregeln wie Zwölftontechnik bis hin zu Stochastik. Bei Hillers zweitem Projekt, der Computer Cantata, kam ein spezielles Kompositionsprogramm namens MUSICOMP zur Anwendung.

In den Bell Laboratories in den USA beschäftigte sich Max V. Matthews ursprünglich mit künstlicher Sprachsynthese. Um den IBM 7090 als Klangerzeuger zu verwenden, unterteilte er den Klangsyntheseprozess in zwei Phasen: in der ersten wurden die Momentanwerte der Wellenform in einem Datenspeicher (Magnetband) abgenommen; in der zweiten wurden die gespeicherten Werte ausgelesen und in digitale Tonsignale umgewandelt. Um die großen Zahlenmengen durch wenige musikalische Parameter zu ersetzen, entstand die MUSIC Computerprogramm-Familie. Bei dem Programm MUSIC III (1960) konnten erzeugte Klänge zur Modulation weiterer Oszillatoren eingesetzt werden. Unter dem Titel The Technology of Computer Music lieferte Max Matthews gemeinsam mit seinen Mitarbeitern eine gründliche Beschreibung der Programmiersprache MUSIC V, die in den 1970er Jahren auf dem Gebiet der Computerklangsynthese einen bedeutenden Meilenstein markierte. Das später durch Miller Puckette bekannt gewordene Programm Max/MSP (1997) ist nach Matthews benannt.

Eines der ersten Hybridsysteme (analog und digital) war der 1970 von Max Matthews und John R. Pierce in den Bell Telephone Laboratories konstruierte GROOVE-Synthesizer. Der Komponist hatte hier die Möglichkeit, sein zuvor programmiertes Stück in verschiedenen Interpretationen wiederzugeben. Zur selben Zeit wurde das Hybridsystem MUSYS von David Cockerell, Peter Grogono und Peter Zinovieff in England entwickelt.

Ende der 1970er Jahre entstanden sogenannte Gemischte Digitale Systeme, bei denen ein Computer einen anderen klangerzeugenden Computer steuern konnte. Pionierarbeit leisteten hier die Electronic Music Studios. Ab 1976 entwickelte Giuseppe Di Giugno für das Pariser Klangforschungsinstitut IRCAM mehrere digitale Synthesizer unter Beratung von Pierre Boulez und dem Komponisten Luciano Berio. Ebenfalls wurde an der University of Toronto der SSSP-Digital-Synthesizer von einer Forschungsgruppe konstruiert. In Australien wurde der Fairlight CMI entworfen. Gleichzeitig wurde von den Amerikanern Jon Appleton, Sydney Alonso und Cameron Jones das Synclavier entwickelt.

Zur zentralen Kategorie musikalischer Abläufe wurde für Iannis Xenakis die Dichte von Klangerzeugnissen und ihre Anordnung nach den Gesetzen mathematischer Wahrscheinlichkeit. Er benutzte für seine ersten Werke einen IBM-7090-Rechner. Musikalische Experimente ergaben sich hierbei mit der Spieltheorie, der Gruppentheorie und der Reihentheorie. Mit dem System UPIC konnten dabei größere Anforderungen an den Rechner vorgenommen werden.

Anfang 1983 einigten sich führende Synthesizer-Hersteller auf einen einheitlichen Standard, damit eine größere Anzahl an Synthesizertypen durch möglichst viele Computertypen steuerbar wird: Musical Instrument Digital Interface, kurz MIDI.

Komposition

Auch die Komposition von Musik kann mithilfe von Computern erfolgen. Partitursynthese ist ein Anwendungsbereich der rechnerunterstützten Komposition in Form von rechnergenerierten Partituren. In einer Reihe von Ansätzen wurde versucht, derartige Strukturen durch Programmierung abzubilden, anfangs etwa mit der Programmiersprache Fortran.

- siehe Hauptartikel Algorithmische Komposition

Klangsynthese

Mit der fortschreitenden Entwicklung der Elektronik und der Digitaltechnik wurden die Verfahren der Klangsynthese zunehmend flexibler und leistungsfähiger.

Additive Klangsynthese

Die additive Synthese ist zur Klangsynthese von Interesse, grundsätzlich ist ihre Anwendung jedoch nicht an digitale Signalverarbeitung gebunden.

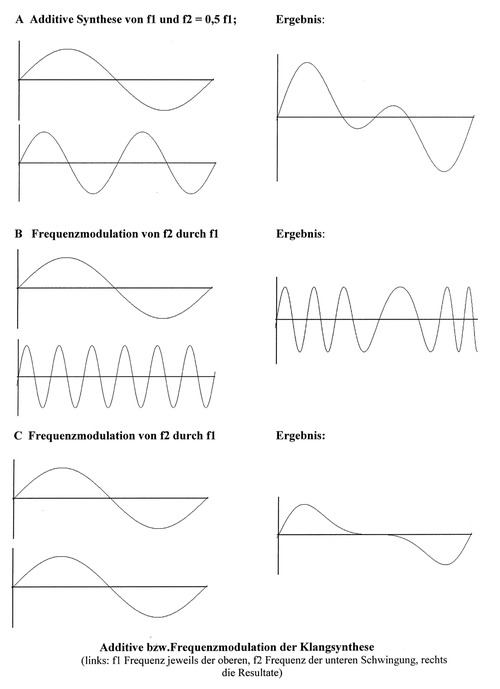

Ein Klang erweist sich auf dem Bildschirm eines Oszillografen als periodische, nicht sinusförmige Kurve (so z. B. rechtes Bild der Abb. A). Wie Jean Baptiste Fourier festgestellt hat, kann jede periodisch verlaufende Schwingung als Überlagerung von sinusförmigen Kurven (verschiedenster Frequenz und Amplitude) aufgefasst werden. Dies ergibt die Möglichkeit, Klänge (periodische Kurven) durch Addition einzelner Töne (schlichte Sinuskurven) zusammenzusetzen (Klangsynthese). Durch Auswahl und Variation z. B. der Amplitude der einzelnen Komponenten ergibt sich eine Vielzahl von verschiedenen Klängen (Additive Synthese) (vgl. Abb. A). Da jedoch ein Klang, z. B. der der auf dem Klavier angeschlagenen Taste a' (mit der Grundschwingung 440 Hz), sich während seiner Dauer ändert (Jean Claude Risset), reicht diese einfache Klangsynthese zur Erzeugung eines echten Klavierklanges nicht aus. Ganz wesentlich hierfür erweist sich u. a. der Einschwingvorgang, d. h. wichtig ist der Zeitraum, in dem sich der Klang aufbaut. Darüber hinaus trägt farbiges Rauschen, das aus fast unendlich vielen Teilschwingungen mit einem Frequenzmaximum besteht, in besonderem Maße zum Klang bei.

Eine wichtige Charakteristik sind die zeitlichen Differenzen beim Auf- und Abbau von Obertönen; jeder einzelne Oberton besitzt gewissermaßen seine eigene komplexe Hüllkurve. Bei elektronischen Orgeln bleibt die Realisierung des additiven Syntheseprinzips auf das kontrollierte Hinzufügen einiger, in festen Intervallen zum Grundton gestimmten sinusförmigen Oberwellen beschränkt (meist weniger als zehn). Daher ist hier keine Hüllkurvenbeeinflussung möglich.

Die Schnelle Fourier-Transformation erreichte hier durch mehrere kleinere Computersysteme eine Reduzierung der Speicherplatzbedarf. Für eine vollwertige additive Synthese ist die separate Beeinflussung der einzelnen Hüllkurven notwendig. Ob eine gemeinsame Hüllkurve für alle Obertöne, oder die einzelne Programmierung für mehrere Obertöne eines Klanges – die Klangergebnisse unterscheiden sich deutlich in der Qualität. Hüllkurven-Kopierfunktionen können hier Hilfe leisten.

Synthese durch Frequenzmodulation

Ändert sich die Frequenz f eines Tones periodisch, so bezeichnet man diese Tonhöhenschwankungen als Vibrato. Man sagt, der Ton sei frequenzmoduliert (vgl. Abb. B). Nähern sich Trägerfrequenz und Modulationsfrequenz (siehe Abb. C), so ergeben schon wenige Wellenformen, z. B. die beiden in der Abb. C, reiche Resultate. Diese FM-Synthese ist einerseits weniger aufwändig als die additive Klangsynthese und außerdem eine flexiblere Technik, weil Träger- und Modulationsschwingungen jedwede Form (nicht bloß Sinusschwingungen) annehmen dürfen und sich so völlig neue Klänge synthetisieren lassen.

- siehe Hauptartikel FM-Synthese und Frequenzmodulation

Synthese durch Amplitudenmodulation

Beim analogen Synthesizer ist es möglich, die Stärke der Modulationsspannung sowie deren Frequenz zu verändern. Dazu wird i.d.R. der Modulationsoszillator LFO verwendet. Die untere Grenze seines Frequenzbereiches beginnt außerhalb der menschlichen Hörfläche (etwa bei 0,01 Hz). Moduliert man die Lautstärke eines Klanges im VCA mit einer LFO-Frequenz, die innerhalb des Bereiches von 0,01 bis 16 Hz ansteigt, so erfährt dieser Klang in Abhängigkeit von Modulationsfrequenz und -stärke zunehmende rhythmische Veränderungen. Der bekannte Tremolo-Effekt steigert sich bis zu einer eigentümlichen Rauheit des Klanges; man spricht hier von subauditiver Steuerung. Erst durch die Erhöhung der LFO-Frequenz in den menschlichen Hörbereich entsteht ein stationärer Klang.

- siehe Hauptartikel LFO und Amplitudenmodulation

Wellenform-Synthese

Den Ausgangspunkt der Wellenform-Synthese bildet eine Sinuswelle, deren Amplitude von einem Hüllkurvengenerator kontrolliert wird. Diese Welle passiert eine Baugruppe, die als nichtlinearer Prozessor (engl. waveshaper) bezeichnet wird. Der Prozessor formt dabei die obertonlose Sinuswelle in ein Klangsignal mit wechselndem obertonanteil um. Die Firma Casio entwickelte Anfang der 1980er Jahre die Phase Distortion-Synthese, eine Variante der Wellenform-Klangsynthese, die 1988 zur Interactive Phase Distortion erweitert wurde.

- siehe Hauptartikel Wavetable-Synthese

Sound-Sampling

Sound-Sampling ist ein digitales Verfahren zur Speicherung von Klängen. In der Praxis ist Sound-Sampling als Kombination mit digital und analog vorgenommenen Klangmanipulationen bereits eine eigenständige Klangsynthesetechnik geworden, obwohl es sich vom Prinzip her um die Wiedergabe bereits vorhandener Klänge handelt. Mit zunehmender Speicherkapazität von Rechnern konnten Wellenformen mechanischer Instrumente mit enormem Speicher und deren Ein- und Ausgangsvorgänge in einer Wavetable im Computer gespeichert werden. Durch Manipulation (Filter, Modulatoren, u. a.) dieser Werte lassen sich Klänge verändern sowie Effekte (z. B. Hall) hinzufügen. Da einerseits das Hören als analoger Vorgang angesehen werden kann, der Computer auf der anderen Seite eine digitale Maschine ist, müssen bei der Ausgabe die diskreten Zahlen des Computers in glatte (elektrische Spannungs-)Kurven umgewandelt werden, um letztlich per Lautsprecher hörbar gemacht zu werden. Dies geschieht über Digital-Analog-Wandler. Umgekehrt gelangen analoge Schallereignisse in den Computer, wenn Analog-Digital-Wandler eingesetzt werden. In diesem Fall können momentane Amplituden (Hochwerte) einer Schallkurve – ein reiner Ton, über ein Mikrofon aufgenommen und auf dem Bildschirm eines Oszillographen (= Schwingungsschreiber) sichtbar gemacht, ergibt eine Sinuskurve – in kleinen Zeitschritten abgetastet werden, wobei aus der (glatten) Schallkurve eine Treppenkurve entsteht, die umso besser sich dem Original nähert, je mehr Abtastungen in der Zeiteinheit stattfinden, je höher also die Abtastrate ist. Setzt sich die Schallkurve aus mehreren Sinuskurven zusammen, wird also ein Klang aufgenommen, so muss nach dem Abtasttheorem von Nyquist und Shannon (1948) die Abtastrate doppelt so hoch angesetzt werden wie die höchste der in der Summe vorkommenden Frequenz (Schwingungszahl f, gemessen in Hertz (Hz)), soll der gespeicherte Klang in all seinen Feinheiten vollkommen aufgezeichnet oder wiedergegeben werden. Wenn z. B. auf einer Compact Disc die Abtastrate (Samplingfrequenz) 44,1 Kilo-Hertz beträgt, dann liegt die höchste (theoretisch) vorkommende Frequenz f bei 22,05 Kilo-Hertz.

- siehe Hauptartikel Sampling (Musik)

Physical Modelling

Wenn ein Instrumentalklang mathematisch analysiert wird, können durch mathematische Vorgaben Klänge entstehen. Wegen sehr hohen Rechenanforderungen hat man nach Ersatzmodellen (Julius O. Smith) gesucht, indem z. B. elektrische Wellenleiter anstelle von Longitudinalwellen in einem Rohr, wie sie in einer schwingenden Pfeife vorkommen, untersucht werden.

- siehe Hauptartikel Physikalische Modellierung

Granularsynthese

Granularsynthese bezeichnet eine Sample-Methode, durch die Klänge aus extrem kurzen Fragmenten herstellt werden können. Formen der Granularsynthese sind Glisson-Synthese, Pulsar-Synthese u.a. (Curtis Roads).

- siehe Hauptartikel Granularsynthese

Klangsteuerung

Sequenzer-Programme

Sequenzer- bzw. Composer-Programme dienen der externen Tonhöhensteuerung. Die Tastatur eines Synthesizers wird hier durch einen Computer ersetzt, der den Synthesizer mit zuvor programmierten Tonhöhenabläufen steuert. Entweder können musikalische Parameter einzeln eingegeben werden oder Töne werden in Echtzeit eingespielt, gespeichert, und verändert.

Audioeditor-Programme

Um den Prozess der Klangsynthese anschaulich zu steuern, werden Sound-Editor- bzw. Voicing-Programme verwendet. Vorteilhaft sind dabei die graphische Darstellung der Parameter sowie dynamische Klangverläufe wie Hüllkurvendarstellungen auf dem Bildschirm. Der Trend geht hier zu universellen, für mehrere Synthesizertypen gleichzeitig verwendbaren Editorprogrammen.

Tracker-Programme

Tracker bezeichnen Software-Sequenzer-Programme; die Audioschnittstellen sind meist alphanumerisch, Parameter oder Effekte werden hexadezimal eingegeben.

Literatur

- Hubert Kupper: Computer und musikalische Komposition. Braunschweig 1970

- Curtis Roads: The Computer Music Tutorial. MIT Press 1996

- Martin Supper: Computermusik. in: MGG — Die Musik in Geschichte und Gegenwart. Allgemeine Enzyklopädie der Musik. Kassel 1995, Sp. 967-982

- André Ruschkowski: Soundscapes - Elektronische Klangerzeugung und Musik, 1. Auflage 1990

Siehe auch

Weblinks

- Benjamin Kempe, Eugen Staab: Lejaren Hiller - Informationstheorie und Computermusik (PDF) - Seminarvortrag, Universität des Saarlandes, 12/2002

- SuperCollider - Programmierumgebung und Programmiersprache für Echtzeit-Klangsynthese und algorithmische Komposition.

Einzelnachweise

- ↑ Paul Doornbusch: The Music of CSIRAC, Australia's First Computer Music. Common Ground Publishers, Australia 2005, ISBN 1-86335-569-3 (with accompanying CD recording).

Wikimedia Foundation.