- Unkorreliert

-

Die Korrelation beschreibt die lineare Beziehung zwischen zwei oder mehr statistischen Variablen. Wenn sie besteht, ist noch nicht gesagt, ob eine Größe die andere kausal beeinflusst, ob beide von einer dritten Größe kausal abhängen oder ob sich überhaupt ein Kausalzusammenhang folgern lässt. Ebenso kann eine strikt nichtlineare Beziehung nicht durch die Korrelation beschrieben werden.

Inhaltsverzeichnis

Nähere Beschreibung

Es gibt positive und negative Korrelationen. Ein Beispiel für eine positive Korrelation (je mehr, desto mehr) ist: Je mehr Futter, desto dickere Kühe. Ein Beispiel für eine negative Korrelation (je mehr, desto weniger) ist: „Je mehr zurückgelegte Strecke mit dem Auto, desto weniger Treibstoff ist vorhanden.“

Häufig benutzt man zu Recht die Korrelation, um einen Hinweis darauf zu bekommen, ob zwei statistische Größen ursächlich miteinander zusammenhängen. Das funktioniert immer dann besonders gut, wenn beide Größen durch eine „Je...desto“ Beziehung miteinander zusammenhängen und eine der Größen nur von der anderen Größe abhängt.

Beispielsweise kann man unter bestimmten Bedingungen nachweisen, dass Getreide umso besser gedeiht, je mehr man es bewässert. Hängt die Menge oder Qualität des Getreides jedoch zusätzlich zum Wasser noch von anderen Variablen ab (beispielsweise von der Temperatur, dem Nährstoffgehalt des Bodens, dem einfallenden Licht usw.), „verwäscht“ der kausale Zusammenhang in der Statistik immer mehr, falls nicht gleichzeitig diese Variablen auch untersucht werden.

Die Korrelation beschreibt aber nicht unbedingt eine Ursache-Wirkungs-Beziehung in die eine oder andere Richtung. So darf man über die Tatsache, dass man Feuerwehren oft bei Bränden findet, nicht folgern, dass Feuerwehren die Ursachen für Brände seien.

Die direkte Kausalität kann auch gänzlich fehlen. So kann es durchaus eine Korrelation zwischen dem Rückgang der Störche im Burgenland und einem Rückgang der Anzahl Neugeborener geben, diese Ereignisse haben aber nichts miteinander zu tun – weder bringen Störche Kinder noch umgekehrt. Das heißt, sie haben kausal allenfalls über eine dritte Größe etwas miteinander zu tun, etwa über die Verstädterung, die sowohl Nistplätze vernichtet als auch Kleinstfamilien fördert.

Im Gegensatz zur Proportionalität ist die Korrelation nur ein statistischer Zusammenhang. Es kann nur eine ungefähre Zu- oder Abnahme prognostiziert werden. Eine 200-prozentige Steigerung der Futtermenge kann eine Gewichtszunahme der Kühe von 10 % oder auch von 20 % bewirken.

Abgrenzung Regression / Fehlinterpretation Korrelation

In der Presse werden Korrelationen oft in einer Weise berichtet, die eine direkte Kausalität suggeriert, obwohl eine Gemengelage direkter und indirekter Zusammenhänge besteht. Beispiele für Schlagzeilen:

- Größere Leute verdienen mehr (baz, 25. Oktober 2003)

- Je mehr Lärm im Haus, desto dümmer die Kinder (baz, 4. September 2004)

- Rauchen schadet Ihrer Intelligenz (20min, 17. Dezember 2004)

- Kreative haben mehr Sex (St. Galler Tagblatt, 1. Dezember 2005)

- Glückliche Menschen sind gesünder (20min, 19. April 2005)

- Sozial engagierte Menschen haben einen besseren Gesundheitszustand (benevol SPECTRUM, Mai 2006)

- Senkung der Arbeitslosigkeit erfordert starkes Wirtschaftswachstum (Schlussfolgerung aus der konjunkturellen Korrelation Wirtschaftswachstum/Arbeitslosigkeit – Okunsches Gesetz)

Der Fehlschluss von Korrelation auf Kausation wird auch als Cum hoc ergo propter hoc bezeichnet. Um Kausalitäten wirklich herstellen und Kausalitätsrichtungen definieren zu können, wären im Grunde Experimente nötig, bei denen ein Faktor experimentell festgelegt wird (z. B. der Lärm im Haus) und der andere Faktor gemessen wird (z. B. Intelligenz der Kinder). Solche Experimente würden mithilfe der Regressionsanalyse evaluiert.

Solche Experimente sind oft aus pragmatischen Gründen nicht durchführbar:

- zu lange Dauer

- zu hohe Kosten

- unethisch

Aufgrund ihres Fokus auf den Menschen sind für viele sozialwissenschaftliche und medizinische Fragestellungen nur korrelative Studien ethisch rechtfertigbar. Um Korrelationsergebnisse als kausal interpretieren zu können, sind weitere Untersuchungen erforderlich (dabei können z. B. langzeitige Zusammenhänge hilfreich sein). Teilweise werden korrelative Studien fälschlicherweise wie Experimente interpretiert.

Erschwerend kommt hinzu, dass bei einfachen Korrelationsanalysen nach Pearson und bei Regressionsanalysen mathematisch ganz ähnliche Verfahren zum Tragen kommen, insbesondere sind r und p identisch (wobei bei Regressionsanalysen r² angegeben wird). Dies fördert die falsche Vermutung, die beiden Verfahren mit ihren jeweiligen Interpretationsmöglichkeiten seien austauschbar.

Für die Korrelation zufälliger Größen (exakter: Zufallsvariablen) siehe Korrelationskoeffizient.

Technische Anwendung

In der Physik, Elektrotechnik und allgemeinen Signalverarbeitung ist die Korrelation von großer Bedeutung. Angewendet auf eine beliebige Funktion mit einer gewünschten zweiten Funktion, ist sie allgemein betrachtet stets ein Maß dafür, wie ähnlich sich die zu untersuchenden Funktionen sind.

Die Funktionen können grundsätzlich kontinuierlich (bzw. stetig) oder diskret (Abtastwerte) sein. Beispiele hierfür können Funktionen über die Zeit oder über den Ort sein. Zeitfunktionen sind bei der zeitlichen Signalverarbeitung relevant. Funktionen über eine Ortsvariable sind vor allem bei der Bildverarbeitung von Bedeutung. Signale, wie sie in der Natur vorkommen, können als Funktionen abgebildet oder interpretiert werden.

Anwendungen der Korrelation sind: Bei Zeitfunktionen werden beispielsweise empfangene elektromagnetische Wellen mit den gesendeten elektromagnetischen Wellen korreliert. Hierbei werden zeitliche Signalfolgen (über die Zeitvariable t) korreliert, wobei das Wellenspektrum dabei beliebig sein kann. Ein Beispiel ist die Verarbeitung von Radarsignalen. Hier wird z. B. das empfangene Radarecho mit dem gesendeten Radarsignal korreliert bzw. verglichen, um zu sehen, ob es sich um das eigene oder ein fremdes Radarecho handelt (z. B. im militärischen Bereich). Ein ähnliches Beispiel ist die Erkennung von Mikrowellensignalen bzw. Signalfolgen, z. B. bei Mobiltelefonen und anderen drahtlosen Applikationen.

Die Korrelation der zeitbasierten Signale bzw. Informationen werden häufig hardware- oder softwaremäßig auf der jeweiligen Elektronik (z. B. FPGA, Signalprozessor) realisiert. Ein entscheidender Faktor für die Rechengeschwindigkeit ist die jeweilige Zeitbasis. Je feiner bzw. genauer die Zeiteinheiten sind, desto größer ist der Rechenaufwand.

Die Korrelation ist gerade bei der Bildverarbeitung ein- oder mehrdimensionaler Daten bzw. Bilder von großer Bedeutung. Bei der Bildverarbeitung wird jedoch der Zeitfaktor (z. B. t) durch eine Ortsvariable (z. B. x) einfach ersetzt. Das Bild wird gewissermaßen als Signalfolge über den Ort interpretiert. Anders als bei Zeitfunktionen liegen bei Bildern nicht eine Zeitbasis sondern Bildpunkte vor, die sogenannten Ortsfrequenzen. Die Ortsfrequenzen sind gewissermaßen die Auflösung des Bildes. Bei der Korrelation zweidimensionaler Bilder sind entsprechend zwei statt einer Ortsvariablen anzusetzen.

Bei der Bildverarbeitung kann dann beispielsweise mittels Autokorrelation festgestellt werden, ob oder wo sich ein bestimmtes Objekt in einem Bild befindet. Das heißt Objekterkennung ist möglich.

Im Gegensatz zur Korrelation von eindimensionalen zeitlichen Signalfolgen erfordert die Korrelation zweidimensionaler Signalfolgen (Bildverarbeitung: Familienphoto, Objekterkennung) einen ungleich höheren zeitlichen Berechnungsaufwand. Je nach Auflösung des Bildes sind entweder Sekunden, Stunden oder auch Tage nötig. Bei herkömmlichen Computern stellt dies ein großes Problem dar, wenn die Korrelation in Echtzeit erfolgen muss.

Daher bietet sich gerade für die Bildverarbeitung von Bildern mit hoher Auflösung (z. B. 50x50 Millionen*Millionen Bildpunkten) der Einsatz von sog. optischen Rechnern an, welche die Vorzüge der Fourieroptik anwenden. Die Rechengeschwindigkeit eines optischen Rechners ist äußerst hoch und erfolgt quasi in Echtzeit. Dabei ist bei dieser Implementierung die Rechengeschwindigkeit völlig unabhängig von der erforderlichen Bildauflösung. Die Bildauflösung selbst ist nur durch die Beugungsbegrenzung eingeschränkt. Die Rechengeschwindigkeit berechnet sich einfach aus der Lichtgeschwindigkeit multipliziert mit der tatsächlichen Baulänge des optischen Rechners und der Berücksichtigung der Verarbeitungsgeschwindigkeiten der ggf. erforderlichen Ein- und Ausgabeelektronik.

Eine Anwendung der Korrelation von Bildern ist beispielsweise die Erkennung von bestimmten Objekten oder Strukturen. Strukturen können hierbei sein: Das Muster eines Schüttguts (Größe oder Form), das Karomuster einer Tischdecke, Erkennung von Krebszellen, Unterscheidung von funktionellen oder nicht funktionellen Blutkörperchen, oder andere Güter. Diese Anwendung ist sehr interessant, wenn die Aufgabenstellung die Erkennung oder Sortierung von Objekten ist (gut oder schlecht bzw. Größe). Interessant wäre der Nachweis manipulierter Bilder, wie Geldscheine.

Weiterhin können Bilder unter Zuhilfenahme der Korrelation selbst verändert werden, indem bestimmte Strukturen (Oberwellen) ausgefiltert werden. Beispiel: Befreiung der Aufnahme eines Fernsehbildschirms von dessen Bildpunkten, um ein glattes Bild zu erhalten. Um die Bildinformation der Bildschirmmaske zu entfernen, werden lediglich alle Frequenzanteile ausgefiltert, welche die Bildpunkte ausmachen. Übrig bleibt ein Bild ohne Bildpunkte. Eine nachträgliche Analyse gibt Aufschluss darüber, welche Frequenzanteile fehlen.

Eine weitere Anwendung wäre die Verschlechterung oder Verbesserung der Auflösung eines Bildes. Allerdings nur bis zur Auflösung, welche das optische Aufnahmesystem physikalisch erzeugen konnte.

Quantitative Beschreibung

Der Ausdruck Korrelation wird oft auf spezielle Weise auf den statistischen Zusammenhang zweier Ereignisse bezogen. Zur Quantifizierung der statistischen Korrelation dienen unter anderem der Korrelationskoeffizient oder – aus der Informationstheorie stammend – die Transinformation und die Kullback-Leibler-Divergenz.

Korrelationskoeffizienten wurden mehrfach – so schon von Tönnies – entwickelt, heute wird allgemein der von Pearson verwendet. Daneben gibt es allerdings auch so genannte nicht-parametrische Testverfahren, z. B. die Spearman-Rangkorrelationskoeffizient oder die Kendall-Rangkorrelation.

Hier sollen die Zusammenhänge aus Sicht der Signalverarbeitung/Signalanalyse mit zeitkontinuierlichen Signalen beschrieben werden.

Das Korrelationsintegral

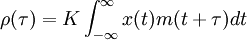

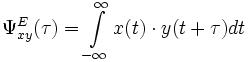

Die Korrelation ist mathematisch durch das Korrelationsintegral für Zeitfunktionen beschrieben:

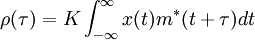

Für komplexe Zeitfunktionen gilt:

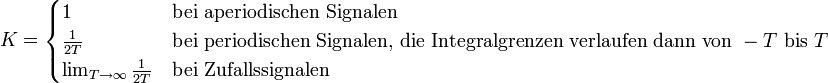

Der Wert K und die Integralgrenzen müssen den entsprechenden Funktionen angepasst werden:

x(t) ist die zu analysierende Funktion, m(t) ist die Musterfunktion.

Musterfunktion m(t)

m(t) kann jede beliebige Musterfunktion sein. Sie sollte jedoch sinnvoll angepasst werden.

Das Korrelationsintegral geht je nach Musterfunktion m(t) über in andere Signaltransformationen:

- Fourier-Transformation: m(t) = e − iωt

- Hilbert-Transformation:

- Autokorrelation: m(t) = x(t)

- Kreuzkorrelation: m(t) = y(t)

- Flächenberechnung: m(t) = 1

- Walsh-Hadamard-Transformation

- Wavelet-Transformation

Korrelationsfaktor als Maß für die Ähnlichkeit zweier Signale

Die Ähnlichkeit zweier Signale wird zunächst anhand zweier reellwertiger Energiesignale beschrieben, anschließend anhand zweier reellwertiger Leistungssignale. Die komplexwertigen Signale werden hier nicht weiter behandelt.

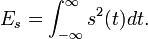

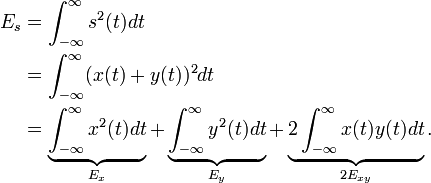

Die Signalenergie Es eines reellwertigen Signals s berechnet sich bekanntermaßen zu

Betrachtet man zusammengesetzte Signale s(t) = x(t) + y(t), so führt das auf die Gleichung

Ex ist die Energie von x, und Ey ist die Energie von y. Die Größe Exy heißt Kreuzenergie. Sie kann positiv, negativ oder null sein.

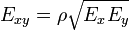

Es ist zweckmäßig, die Kreuzenergie mit den Signalenergien über die Gleichung

in Beziehung zu setzen.

Der Faktor ρ ist der Korrelationsfaktor, auch Korrelationskoeffizient genannt. Für ihn gilt stets:

, was mit Hilfe der Cauchy-Schwarzschen Ungleichung aus der Analysis bewiesen werden kann.

, was mit Hilfe der Cauchy-Schwarzschen Ungleichung aus der Analysis bewiesen werden kann.Die Energie des Gesamtsignals hängt nach den eben gemachten Ausführungen von der Signalenergie von x, der Signalenergie von y und dem Korrelationsfaktor ρ ab.

Der Korrelationsfaktor hat den Wert ρ = 1, wenn man das Signal x(t) mit dem Signal y(t) = | k | x(t) korreliert. Man nennt das Signal in diesem Fall gleichläufig. Die Signalenergie des Gesamtsignals ist maximal.

Der Korrelationsfaktor hat den Wert ρ = − 1, wenn man das Signal x(t) mit dem Signal y(t) = − | k | x(t) korreliert. Man nennt das Signal in diesem Fall gegenläufig. Die Signalenergie des Gesamtsignals ist minimal.

Eine Besonderheit liegt vor, wenn der Korrelationsfaktor den Wert ρ = 0 annimmt. Man nennt beide Signale dann orthogonal (bei Energiesignalen darf man auch sagen: unkorreliert).

Der Korrelationsfaktor ist, wie an den Beispielen klar wird, ein Maß dafür, wie ähnlich sich zwei Signale sind.

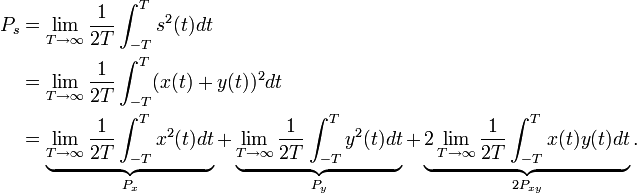

Bei Leistungssignalen finden sich ähnliche Zusammenhänge. Für die Signalleistung Ps eines Signals s(t) = x(t) + y(t) ergibt sich

Hier bestimmt der Kreuzleistungsfaktor

den Grad der Übereinstimmung beider Signale. Für

den Grad der Übereinstimmung beider Signale. Für  nennt man beide Signale orthogonal. Je größer

nennt man beide Signale orthogonal. Je größer  ist, umso größer ist die Wahrscheinlichkeit, dass beide Signale etwas miteinander zu tun haben.

ist, umso größer ist die Wahrscheinlichkeit, dass beide Signale etwas miteinander zu tun haben.Kreuzkorrelationsfunktion

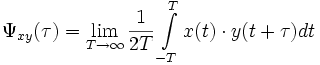

Der Begriff der Kreuzenergie bzw. Kreuzleistung wird in der Signalverarbeitung zum Begriff der sogenannten Kreuzkorrelationsfunktion KKF erweitert.

Man schaut sich dann nicht allein die Kreuzenergie zwischen x und y an, sondern man betrachtet die Kreuzenergie von x mit dem beliebig zeitverschobenen Signal y(t + τ).

Damit wird ein Zusammenhang beider Funktionen auch dann erkannt, wenn die Funktionen gegeneinander zeitverschoben sind und die Wirkung nach der Ursache einsetzt.

Aus Sicht der Signaltheorie unterscheidet man wieder zwischen sogenannten Leistungssignalen, z. B. periodische Signale mit endlichen Signalwerten, und den Energiesignalen, wie z. B. Signale endlicher Länge.

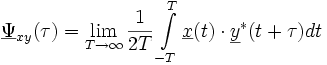

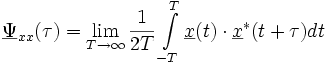

Die Kreuzkorrelationsfunktion (KKF) eines reellwertigen Leistungssignals berechnet sich zu

.

.

Bei Energiesignalen ergibt sich

.

.

Bei der Erweiterung zu komplexen Signalen wird das Konjugiert-Komplexe y * von y verwendet

.

.

bzw.

.

.

Die häufigste Anwendung der KKF dürfte die Suche nach Signalverschiebungen sein. Liegen das Signal x und das zeitverschobene Signal x(t − t0) vor, so kennzeichnet das Maximum der Kreuzkorrelationsfunktion genau die Zeitverschiebung t0.

Sendet man beispielsweise ein akustisches Signal aus und wartet auf sein Echo, so zeigt die KKF von Signal und Echo an, mit welcher Zeitverzögerung das Echo zurückgekommen ist.

Dieses Verfahren funktioniert praktisch auch dann noch relativ gut, wenn beide Signale verrauscht sind.

Das hat etwas damit zu tun, dass das Maximum der KKF angibt, mit welcher Zeitverschiebung t0 sich Signal und Echo am ähnlichsten sind (Prinzip der minimalen Fehlerquadrate).

Autokorrelationsfunktion

In der Signalverarbeitung nutzt man für verschiedene Anwendungen die Kreuzkorrelationsfunktion eines Signals mit sich selbst, die sogenannte Autokorrelationsfunktion.

Die Autokorrelationsfunktionen beschreiben die Ähnlichkeit eines Signals bzw. einer Zeitfunktion mit sich selbst.

Definition

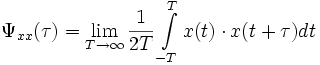

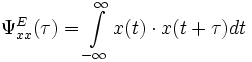

Die Autokorrelationsfunktion (AKF) eines reellwertigen Leistungssignals berechnet sich zu

.

.

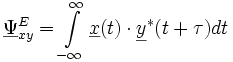

Bei Energiesignalen ergibt sich in ähnlicher Weise

.

.

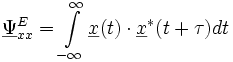

Bei komplexwertigen Signalen ergibt sich:

.

.

bzw.

.

.

wobei der Stern die konjugiert komplexe Zahl bedeutet.

Anwendungen

Die Korrelation wird in verschiedenen technischen und wissenschaftlichen Bereichen praktisch eingesetzt.

Anwendung bei Kapitalanlagen

Der Korrelationsbegriff ist von erheblicher Bedeutung bei Kapitalanlagen. Es gilt: Das Gesamtrisiko des gesamten Portfolios ist umso geringer je geringer die einzelnen Anlagen (Assets) miteinander korrelieren.

Beispiel für positive Korrelation: Besteht ein Portfolio nur aus vielen einzelnen Aktien, so führt der Kursrückgang von Aktie 1 auch zum Wertverlust von Aktie 2 und auch Aktie 3 in einem bestimmten Verhältnis. Besteht das Portfolio jeweils zur Hälfte aus Aktien und Renten, so ist der Verlust geringer, da nur eine geringfügige Korrelation Aktien-Renten besteht.

Allerdings gibt es auch (negative) Korrelationen, wenn auch geringere, bezüglich Aktie-Rente. Ist der Aktienmarkt schwach, so wird tendenziell in Renten investiert (Kapitalflucht in den sicheren Hafen). Die Rentenkurse steigen. Dies fängt jedoch nicht den Komplettverlust im Aktienbereich auf. Daher ist es sinnvoll noch in weitere Anlagen zu diversifizieren als nur in Renten und Aktien (siehe auch Diversifikation). Die Risikominderung durch Diversifikation oder Investition in negativ korrelierte Assets bezeichnet man als Hedging. Dem ist allerdings eine natürliche Grenze dadurch gegeben, dass, wenn zwei Assets negativ korreliert sind, ein dritter nicht mit beiden negativ korreliert sein kann, sondern nur mit dem einen negativ in dem Maße, in dem er mit dem anderen positiv korreliert ist.

Die ideale Diversifikation ist so umfassend, dass keine Korrelationen zwischen den einzelnen Assets existieren. Erwirtschaften zudem die einzelnen, nicht korrelierenden Assets noch eine maximale Rendite, so ergibt sich das ideale, jedoch in Realität nie existierende Portfolio.

Reduktion der Korrelation des Gesamtportfolios im Verhältnis zu seinen Einzelanlagen, verbessert nach dem Markowitz-Modell das Rendite-Risiko-Verhältnis. Auf langfristiger Basis wird damit prinzipiell eine höhere Rendite bei geringerem Risiko erzielt (siehe auch Portfoliotheorie).

Anwendung in der Softwaretechnik

Ein Korrelationstest bezeichnet in der Softwaretechnik ein Verfahren, in dem nicht nur einzelne Parameter einer Funktion auf Plausibilität (zum Beispiel in Datentyp oder Wertebereich) geprüft werden, sondern auch Kombinationen dieser Parameter berücksichtigt werden. Es ist möglich, dass zwar jeder Parameter für sich einen gültigen Wert besitzt, diese in Kombination jedoch ein fehlerhaftes Verhalten der zu testenden Funktion hervorrufen, nämlich wenn diese Parameter durch die Funktion korreliert werden.

Beispiel: Ein rechteckiges Objekt soll auf dem Bildschirm dargestellt werden. Hierzu existiert eine Funktion, die in den Parametern X,Y,SX,SY die Dimension des Rechtecks entgegennimmt.

- Parameter X gibt die X-Position der linken oberen Ecke an. Es muss geprüft werden, ob X im gültigen Anzeigebereich liegt.

- Parameter SX gibt die X-Kantenlänge (Breite des Rechteckes) an. Hier muss zunächst geprüft werden, ob SX die zulässige Anzeigebreite nicht überschreitet.

- Bei einem Korrelationstest wird nun zusätzlich geprüft ob, X + SX im gültigen Wertebereich liegt.

Anwendung in der Bildverarbeitung

In der Bildverarbeitung nutzt man Korrelationsfunktionen unter anderem zur genauen Lokalisierung eines Musters (der Musterfunktion im Sinne der mathematischen Korrelation) in einem Bild. Dieses Verfahren kann z. B. zur Auswertung von Stereobildpaaren verwendet werden. Um die räumliche Koordinate eines Punktes berechnen zu können muss eine eindeutige Zuordnung von Objekten im linken Bild zu den Objekten im rechten Bild existieren. Dazu nimmt man einen kleinen Ausschnitt aus dem einen Bild – das Muster – und korreliert ihn zweidimensional mit dem anderen Bild. Die so erhaltenen Koordinaten eines Objektpunktes oder -merkmals im linken und rechten Bild kann man mit Methoden der Photogrammetrie in räumliche Koordinaten umwandeln.

Die Fotos der Bildfolge links zeigen eine junge Frau, ihr Negativbild, Nietzsche und ein zufälliges Rauschmuster.

Um zu testen, ob das Foto der jungen Frau auch in den verrauschten Bildern wiederzufinden ist, wurden alle vier Bilder zunächst mit einem weißen Gaußschen Rauschen überlagert und dann mit ihrem Foto (erstes Foto der Bildfolge) korreliert.

Das Ergebnis sieht man in der Bildzusammenstellung rechts. Undeutlich zu erkennen sind die Ausgangsbilder. Rechts neben ihnen stehen die Korrelationsrechnungen.

Das Korrelationsbild von Nietzsche zeigt wenig Übereinstimmungen mit dem der jungen Frau, das Rauschmusterbild fast gar keine. Gut zu erkennen ist die positive und negative Korrelation mit den Bildern, die die Frau und ihr Negativ zeigen.

Das Bild-Beispiel stammt aus dem Artikel CDMA, wo es Anwendungen der Korrelationsrechnung bei der Signalanalyse veranschaulicht.

Im weiteren Sinn basieren sog. optische Rechner (Fourier Optik, 4f) auf der Korrelation. Die auch als Fourier-Korrelatoren bezeichneten Systeme korrelieren Bilder mit Hilfe von Hologrammen. Durch eine 4f-Optik lässt sich die Korrelation im Frequenzraum durch einen rein physikalischen Prozess mit nahezu Lichtgeschwindigkeit erzielen. Notwendig ist eine optische Bank mit entsprechendem Linsensystem und Fourierlinse. Die Verarbeitungsgeschwindigkeit eines solchen Systems kann nicht durch digitale Systeme erzielt werden, da die Arbeitsgeschwindigkeit des optischen Systems sich lediglich nach Lichtgeschwindigkeit und Baulänge des optischen Systems richtet.

Anwendung in der Tonverarbeitung

Die Korrelation beschreibt bei der Stereofonie die Ähnlichkeit von Signalen. Der normierte Korrelationsfaktor oder Korrelationskoeffizient ist ein Ähnlichkeitsmaß zweier Signale und berechnet sich vereinfacht aus dem möglichst großen Zeitintegral der Amplitudendifferenz dieser beiden Signale. Er wird angenähert von Korrelationsgradmessern angezeigt, wobei diese in der Praxis allerdings nur einen Phasenbezug mit einer sehr kleinen Integrationszeit unter einer Sekunde untersuchen.

Als Messgerät wird in der Tontechnik der Korrelationsgradmesser oder das Goniometer verwendet.Anwendung in der Mehrkanal-Signalübertragung

In der Nachrichtentechnik werden aus ökonomischen Gründen Verfahren eingesetzt, eine Vielzahl von untereinander unabhängigen Signalen (z. B. die Telefonsignale vieler Teilnehmer oder die Bild- und Tonsignale vieler Fernseh- oder Tonrundfunksender) über das gleiche Übertragungsmedium (Draht, Kabel, Funkstrecken, Lichtwellenleiter) zu übertragen. Um solche Kanalbündel nach der Übertragung, also auf der Empfängerseite, wieder störungsfrei „entbündeln“ zu können, müssen die Einzelsignale „unterscheidbar“ sein. Das bedeutet, dass die senderseitig zu einem Bündel zusammengefassten Einzelsignale untereinander (jedes mit jedem) orthogonal sein müssen. Diese Orthogonalitätsbedingung ist in zwei Fällen trivial erfüllt, nämlich dann, wenn die einzelnen Signale sich spektral oder zeitlich nicht überlappen. In diesem Fall ist bereits das Produkt der Spektren der Einzelsignale oder das Produkt der Zeitfunktionen der Einzelsignale jeweils gleich Null, das Korrelationsintegral daher ebenfalls. Die deshalb auch technisch einfache Realisierung dieser beiden Fälle sind das Frequenzmultiplex- und das Zeitmultiplexverfahren. Mit modernen mikroelektronischen Technologien ist es nun aber auch möglich geworden, orthogonale Signale zu (de)multiplexen, die sich sowohl spektral als auch zeitlich gegenseitig überdecken (Codemultiplextechnik). Hier muss empfängerseitig tatsächlich die Korrelationsfunktion ermittelt werden. Das erfolgt in der Regel durch den Einsatz eines Optimalfilters.

Anwendung beim Signalempfang

Bei jeder Art von Signalübertragung treten Störungen verschiedener Art auf, mindestens aufgrund des thermischen Rauschens von Elektronen oder Photonen, die zur elektrischen oder optischen Signalübertragung notwendig sind. Auf der Empfängerseite entsteht also das Problem, das Signal mit einer maximalen Sicherheit vom Störsignal zu trennen. Das gelingt theoretisch desto besser, je mehr beim Empfänger über das Sendesignal bekannt ist (etwa über den Zeitverlauf eines gesendeten Radarsignals). In diesem Fall ist der Korrelationsempfang, d. h. die empfängerseitige Korrelation des ankommenden gestörten Signals mit einem Muster des Sendesignals die theoretisch optimale Lösung der Empfängerrealisierung. Genau dieses Prinzip wird nicht nur in der Technik, sondern auch in der Natur angewendet bei der Ultraschallortung der Fledermäuse.

Siehe auch

- Korrelationsgradmesser

- Kovarianz

- Kollinearität als Fehlermöglichkeit oder Entgleisungsmöglichkeit

- Korrelationskoeffizient

- Stochastische Unabhängigkeit

Weblinks

Wikimedia Foundation.